Easy Dataset 是一个专为创建大型语言模型(LLM)微调数据集而设计的应用程序。它提供了直观的界面,用于上传特定领域的文件,智能分割内容,生成问题,并为模型微调生成高质量的训练数据。

Read more

模型微调(Fine-tuning) 是指在一个已经训练好的大模型基础上,用特定领域或特定任务的数据继续训练,使模型在某类问题上表现得更好。

开源工具 LlamaFactory 可以轻松地对模型进行微调:https://github.com/hiyouga/LlamaFactory

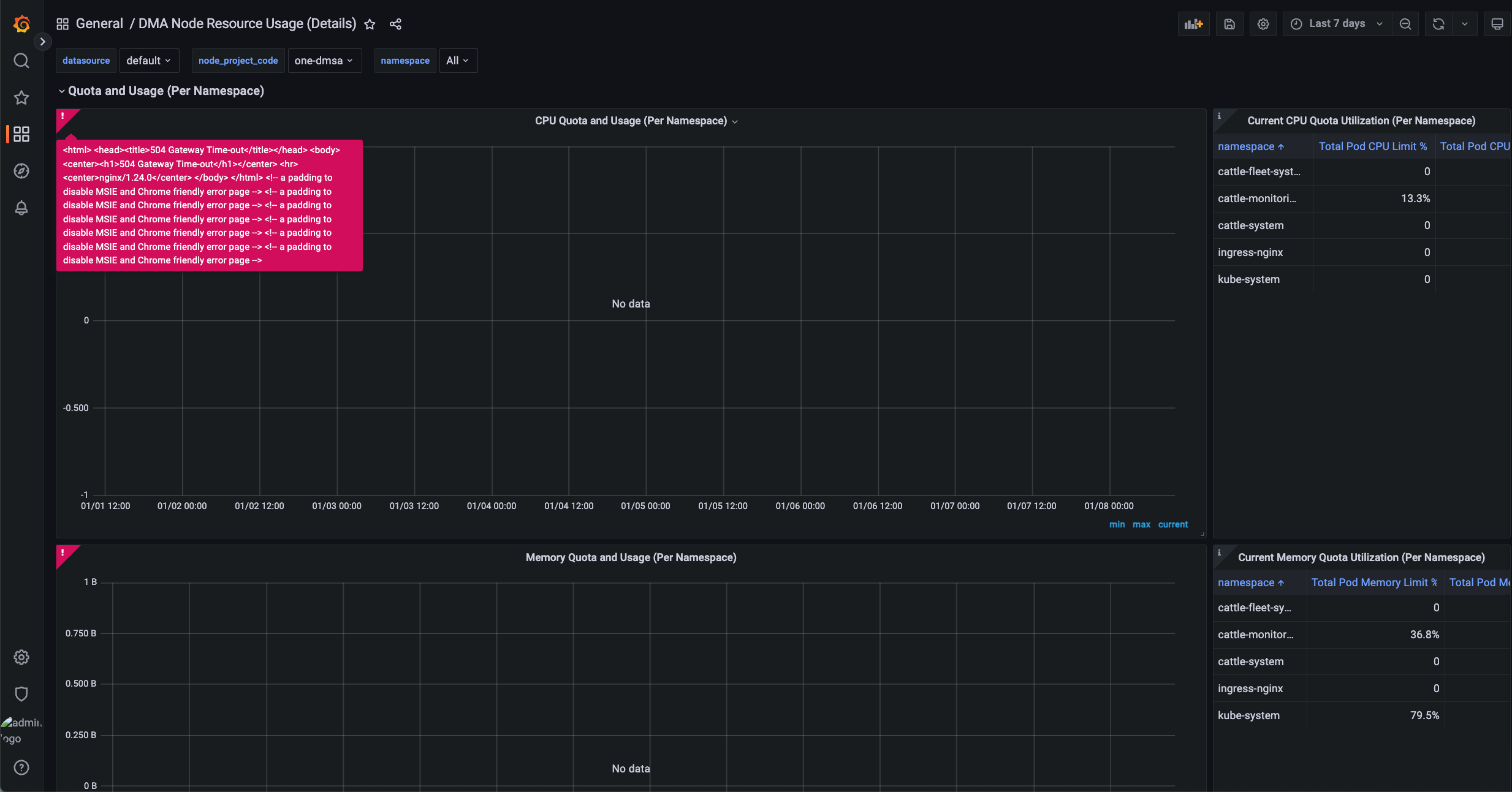

Rancher Monitoring Grafana 出现 504 错误

Rancher Monitoring V2 中,Grafana 通过 Nginx 作为反向代理(grafana-proxy)访问 Prometheus。当 Grafana 执行 PromQL 查询且返回数据量较大(例如查询时间范围较长)时,Prometheus 可能无法在 Nginx 的超时时间内完成响应,从而导致 Grafana 返回 504 Gateway Timeout 错误:

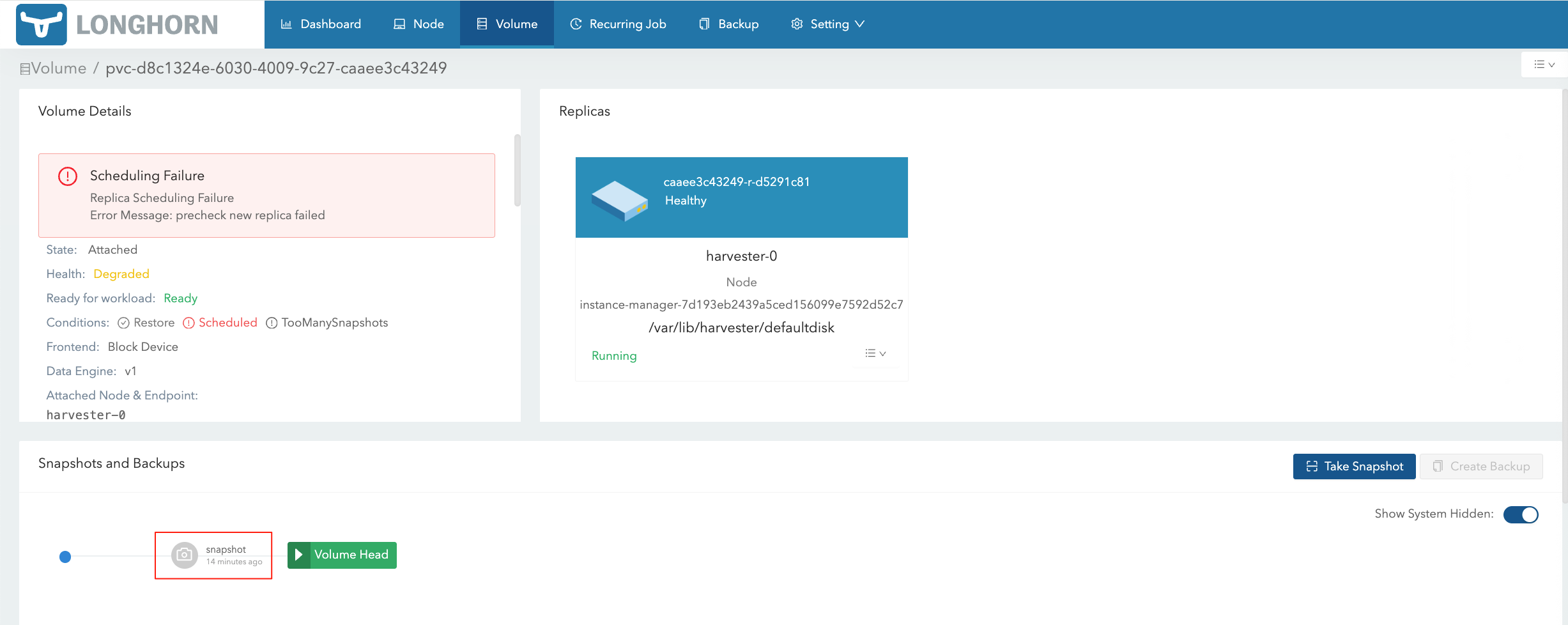

在 HV 将对应的 VM Snapshot 删除后,在 LH 界面仍然能够看到对应的 Volume Snapshot:

Google 的 Firestore Console 无法将 Firestore 数据导出为 CSV/JSON 等格式的文件,经过调研,需要先将 Firestore 数据导出到 GCS,然后再导入 BigQuery 进行格式化,将格式化后的文件导出到 GCS,最后下载到本地。

也可以通过调用 SDK 的方式写代码进行导出。