没有首页 😈

Rancher Elemental 升级报错 error calling index: index of untyped nil

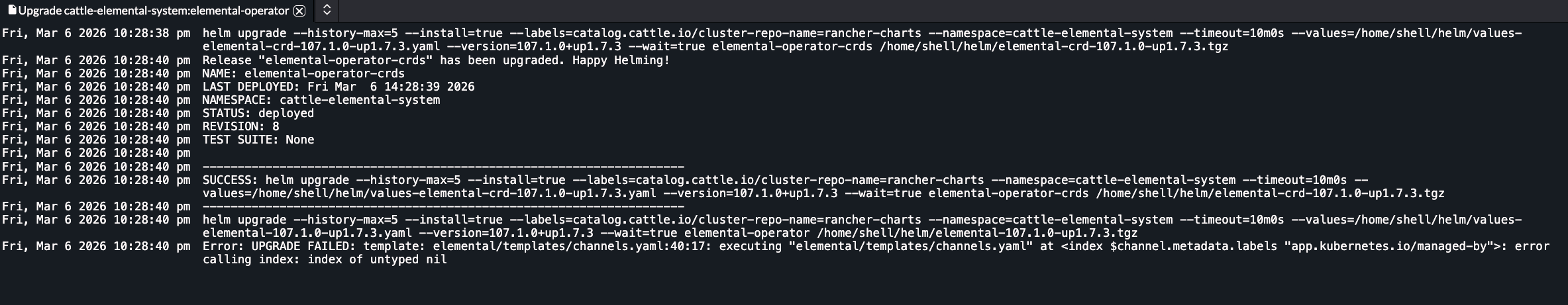

通过 Rancher UI 升级 Elemental 的时候(Helm Upgrade),出现如下报错:

删除手动创建的 Channel,就能正常完成升级。

prof 文件能够用于性能分析,如果 NeuVector 组件出现性能问题(如 CPU 使用率异常高等),可以通过如下方式获取。

在实际开发过程中,不同项目通常依赖不同版本的第三方库,甚至可能存在版本冲突或不兼容的问题。

为了解决依赖隔离问题,Python 提供了 venv 模块,用于为每个项目创建独立的虚拟环境,使项目之间互不影响。